Oggi si parla sempre più dei computer quantistici per il futuro dell’informatica.

Al CES (Consumer Electronic Show) 2018 IBM ha presentato un modello di computer quantistico da 50 Qubit da con un sistema di raffreddamento che può arrivare a 10 millesimi di grado sopra lo zero assoluto. Anche Google ha investito 1 miliardo di dollari sul progetto svolto insieme alla NASA per la realizzazione dei computer quantistici.

A novembre 2023 una startup californiana, la Atomic Computing, è riuscita a realizzare un Computer quantistico da 1000 Qubit ed anche IBM e Google si stanno muovendo per raggiungere questo obiettivo. Per una piena efficienza occorre raggiungere un milione di qubit ed attivare un sistema automatico di correzione degli errori, su cui stanno lavorando altri ricercatori.

Vediamo di comprendere brevemente il funzionamento dei nuovi computer quantistici, che dovrebbero sostituire o svolgere le funzioni di calcolo degli attuali computer con processori al silicio. Questi nuovi computer aumenteranno certamente le capacità di elaborazione, aiutandoci a risolvere quei problemi in campo sanitario e dell’Intelligenza Artificiale, che non riusciamo a superare con gli strumenti attuali, ma possono comportare dei rischi per il controllo delle informazioni da parte di grandi gruppi privati al di sopra di ogni controllo.

Alla fine degli anni ottanta Gordon Moore, uno dei fondatori di Intel, enunciò nella sua forma definitiva la cosiddetta prima legge di Moore secondo cui “il numero di transistori nei processori e quindi la velocità di calcolo sarebbero raddoppiati ogni 18 mesi”. In questi anni la previsione è stata sempre rispettata, ma negli ultimi microprocessori si sta raggiungendo il limite fisico, che presto impedirà di aumentare la densità di transistor con gli attuali materiali.

Questo processo ha anche interessato le dimensioni degli apparati. Basta infatti confrontare le dimensioni dei grandi computer IBM degli anni ’60 con quelle di uno smartphone, che oggi contiene una capacità di elaborazione maggiore. Si calcola che il nostro smartphone è milioni di volte più potente del computer che ha gestito il primo viaggio dell’uomo sulla Luna.

La miniaturizzazione sempre più spinta è ormai arrivata alle soglie del singolo atomo, dove non valgono più le regole della fisica classica, ma quelle della meccanica quantistica, costringendoci ad operare in un modo del tutto nuovo di pensare e costruire computer.

Dalla fisica classica alla meccanica quantistica.

Nella Meccanica classica è possibile conoscere con precisione la posizione e la velocità di un treno e di una pallina, oggetti che vediamo chiaramente dove sono collocati e come si muovono. Inoltre, quando misuriamo la posizione della pallina, non modifichiamo in alcun modo la sua velocità.

Tutto questo non vale nel mondo subatomico delle particelle.

In base agli studi di Einstein, Bohr comprese che sia l’elettrone che il fotone di luce sono al tempo stesso sia un corpuscolo sia un’onda ed Heisenberg mostrò che velocità e posizione, non possono essere misurate entrambe nello stesso momento con precisione, come avviene con una pallina o con gli strumenti della fisica classica.

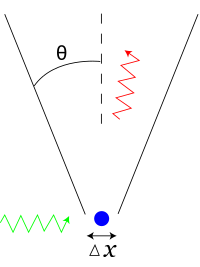

Tanto migliore è la precisione della misura di una delle due grandezze, tanto peggiora la precisione nella misura dell’altra. Infatti, per conoscere la posizione di un elettrone, questo dovrà essere illuminato da un fotone. Più corta sarà la lunghezza d’onda del fotone, maggiore sarà la precisione con cui la posizione dell’elettrone è misurata. Tuttavia, a basse lunghezze d’onda il fotone trasporterà un’energia sempre maggiore, che assorbita dall’elettrone ne perturba sempre di più la sua velocità, rendendo impossibile calcolarne il valore in contemporanea. Al contrario, un fotone ad alta lunghezza d’onda perturberà poco la velocità dell’elettrone, ma sarà in grado di determinare con poca precisione la sua posizione.

Indeterminatezza della posizione secondo la lunghezza d’onda del fotone rilevatore

L’incertezza sulla misura della posizione (∆x) e quella sulla quantità di moto p=mv (∆p) sono messe in relazione dal Principio di indeterminazione di Heisenberg

![]()

Il limite inferiore del prodotto delle incertezze è quindi proporzionale alla costante di Planck h.

Un altro meccanismo presente solo nel mondo subatomico è il cosiddetto entanglement o correlazione quantistica, secondo cui in un sistema costituito da due particelle il valore di una proprietà misurato per una particella influenza istantaneamente il corrispondente valore dell’altra, pur mantenendo in totale il valore globale iniziale.

Per poter operare sulle proprietà di un singolo elettrone, è necessario che questo segua una traiettoria il più regolare possibile, senza incontrare ostacoli e senza scontrarsi con altre particelle. Questo può avvenire solo operando ad una temperatura vicina allo zero assoluto (-273°C). Infatti più sono alte le temperature e più gli atomi ed elettroni si muovono in modo disordinato all’interno della materia.

Lo studio sui computer quantistici si è quindi sviluppato in questi anni tenendo conto del principio di Heisenberg, del meccanismo di Entanglement e della necessità di operare a temperature vicine allo zero assoluto.

Dal Bit al Qubit

Il Bit è la più piccola unità di dati in un computer, che può avere 2 valori: 0 oppure 1. I valori sono determinati dal passaggio o meno di un flusso di elettroni all’interno di un transistor componente dei chip.

0 – Assenza della corrente ; 1 – Passaggio di corrente

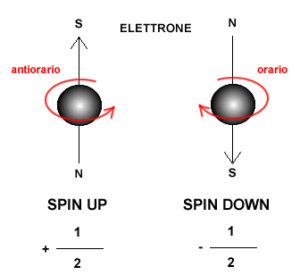

Mentre il bit analizza il movimento di un flusso di elettroni, il Quantum bit (Qubit) esamina il meccanismo di rotazione di un singolo elettrone. Tale proprietà è associata allo spin, che può essere Up (+1/2) o Down (-1/2) secondo se la rotazione dell’elettrone avviene in senso antiorario od orario.

La rotazione antioraria e oraria dello spin e l’insieme di probabilità che la posizione e lo spin dell’elettrone siano comprese tra un valore 0 e un valore 1

Poiché ci troviamo ad esaminare delle particelle come gli elettroni, valgono le regole della Meccanica quantistica e quindi la proprietà dello spin può assumere contemporaneamente i due valori +1/2 o -1/2 ovvero quelli calcolati in base al principio di indeterminazione di Heisenberg.

Dal funzionamento sequenziale all’elaborazione parallela.

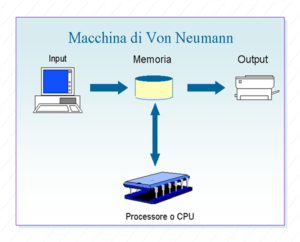

Il funzionamento ON/OFF dei bit, tipico di un flusso di corrente, può effettuare in sequenza una elaborazione alla volta con 2 possibilità, seguendo un processo di input-output definito da Von Neumann.

In un computer quantistico ogni Qubit può trovarsi in una condizione di “sovrapposizione” di quei due stati 0 e 1. Inoltre la proprietà di entanglement crea una correlazione con tutti gli altri Qubit presenti, che consente ai computer di eseguire molti calcoli in una sola volta. Il numero di questi calcoli raddoppia per ogni qubit aggiuntivo e questo meccanismo porta ad una accelerazione esponenziale della potenza di calcolo.

Il Computer IBM presentato al CES 2018 può contare su 50 Qubit e può effettuare una elaborazione con 250, pari ad un valore di 1015 ovvero a un milione di miliardi di bit alla volta. L’ultimo computer quantistico annunciato da Google opera con 72 Qubit e l’obiettivo resta quello di arrivare almeno a 100 Qubit.

Il meccanismo di elaborazione parallela è simile a quello utilizzato dal cervello umano con una rete di 100 Miliardi di neuroni collegati tra loro, che elaborano in parallelo tutti gli input ricevuti e con le sinapsi che agiscono come neurotrasmettitori di segnali elettrici .

Un sistema di elaborazione paralleo costituito da neuroni e sinapsi del cervello umano

il Genoma Umano, l’insieme di informazioni biologiche DNA che determinano le caratteristiche di ogni persona, è composto da circa 3 miliardi di nucleotidi. Per leggere e comprendere tutti i dati contenuti in un Genoma gli attuali super computer che utilizzano un funzionamento sequenziale elaborano un risultato per ogni passaggio e possono impiegare giorni di elaborazione prima di estrarre le informazioni relative ai geni specifici responsabili di malattie rare o tumorali. Un computer quantistico di 50 Qubit, lavorando in modalità parallela, potrebbe elaborare milioni di dati per ogni passaggio ed impiegare molto meno tempo per risolvere le analisi genetiche.

I Qubit conservano il loro stato quantistico solo per millesimi di secondo e quindi ogni operazione dev’essere completata in quel lasso di tempo.

I nuovi computer quantistici sperimentali.

Per evitare movimenti incontrollati e scontri tra particelle, che potrebbero far perdere l’integrità dei dati, occorre garantire una temperatura vicina allo zero assoluto e la massima stabilità del computer quantistico.

Oggi il raffreddamento dei sistemi richiede l’elio e le infrastrutture vengono mantenute in ambienti privi di vibrazioni, mentre le elaborazioni avvengono con algoritmi opportunamente sviluppati per il Quantum computing.

Google, IBM, Microsoft e Intel si stanno sfidando per realizzare prima possibile un computer quantistico che possa dare sempre risultati affidabili ed essere utilizzato su larga scala ed anche la Cina si sta attrezzando per partecipare a questa competizione.

Nell’immagine si può vedere il modello di computer quantistico da 50 Qubit presentato da IBM al CES 2018 con un sistema di raffreddamento che può arrivare a 10 millesimi di grado sopra lo zero assoluto.

A luglio 2018 Google ha anche messo a disposizione il software Cirq per quanti si vogliano cimentare nella programmazione di un computer quantistico, che richiede algoritmi molto diversi da quelli utilizzati per un computer con microprocessori e deve tener conto delle proprietà quantistiche di questo processo.

Potenzialità e rischi.

Computer quantistici con capacità di elaborazione miliardi di volte più potente dei computer attuali possono portare benefici in molti settori che richiedono capacità di calcolo più elevate di quelle oggi disponibili.

Risvolti positivi potrebbero infatti avvenire per:

-

un sequenziamento più veloce dei geni umani contenuti del DNA per sviluppare cure personalizzate ed individuare anomalie genetiche e tumorali;

-

lo sviluppo di nuovi farmaci e delle ricerche in ambito sanitario;

-

un miglioramento delle previsioni meteorologiche a breve e lungo termine, grazie alla enorme capacità di acquisizione dati e di elaborazione di modelli complessi;

-

un migliore controllo del traffico stradale ed aereo grazie all’elevata capacità di acquisire dati aggiornati ed elaborare modelli complessi;

-

un apprendimento più veloce da parte delle macchine per sviluppare l’intelligenza artificiale in molti settori e soprattutto in quello dei veicoli a guida autonoma;

-

un superamento delle attuali tecniche di criptazione, che sarebbero risolte in pochi secondi dai nuovi computer e l’introduzione di nuove tecniche di crittografia quantistica in grado di proteggere i dati da utilizzi malevoli;

-

un’elaborazione più veloce per tutti i programmi e le attività legate al lavoro e ai processi produttivi.

Accanto a queste potenzialità non vanno sottovalutati i rischi, che possono derivare soprattutto dalle caratteristiche fisiche e tecnologiche dei computer quantistici. Infatti, gli attuali computer sono progettati e costruiti per raccogliere ed elaborare dati dalla nostra scrivania o dai server dell’ufficio, dati che a volte salviamo in spazi cloud esterni .

Invece i processori dei computer quantistici, per la necessità di funzionare a temperature vicine allo zero assoluto, potranno essere collocati soltanto nelle sedi di Google e delle altre aziende produttrici. Questa necessità rischia quindi di lasciare in mano a pochi produttori tutta la capacità elaborativa mondiale, con i rischi per la democrazia derivanti dal controllo pieno in poche mani delle elaborazioni e delle informazioni di tutto il pianeta.

Sergio Scalia